Dynamik reaktiver Strömungen, Schadstoffe und Schadstoffausbreitung

Dynamik reaktiver Strömungen, Schadstoffe und Schadstoffausbreitung |

|

Im Anwendungsbereich von Problemen innerhalb Strömungs- und Schadstoffausbreitungssimulationen gibt es eine große Vielfalt in den zur Verfügung stehenden Arbeitsmitteln, beginnend bei einfachen Abschätzungen mittels Handrechenformeln bis hin zu aufwändigen numerischen Simulationen spezifischer Modelle. Für die Beurteilung einer Schadstofffreisetzung bzw. für Fragen zur Freisetzungsprognose von Anlagen im Genehmigungsprozess gibt es zudem umfassende gesetzliche Regelungen und nachgeschaltete Anwendungsvorschriften.

In vielen Fällen leiten sich Normen und Verordnungen aus empirischen Ansätzen ab oder die mathematische Beschreibung ist limitiert auf die Erfordernisse, eine erste nichttriviale Näherungslösung zum Problem, bei gleichzeitig moderatem numerischen Aufwand zu liefern.

Oft ist jedoch insbesondere der Einbezug von Toleranzen, also die detaillierte Fehlerbetrachtung bzw. Betrachtung von möglichen Schwankungen in den Eingangsparametern zum gewählten Szenario, ein großes Problem. Obwohl die grundlegenden Modelle (Strömungsmodelle/ Schadstoffausbreitungsmodelle) sehr weit entwickel sind, werden oftmals (sogar in Publikationen) unzureichend motivierte, fragwürdige, oder (zu) stark simplifizierte Modelle betrachtet.

Eine kritische Auseinandersetzung mit der Bandbreite der denkbaren Ereignisse, eine Toleranzanalyse bzw. die Diskussion der Relevanz und Signifikanz ist oft nicht gegeben. Hier soll speziell der Einfluss von Toleranzen (Fehlereinflüsse durch geeignete Wahrscheinlichkeitsverteilungsfunktionen) über Monte-Carlo-Simulationen (stochastische Modellierung) mit den numerischen Simulationen gekoppelt werden. Dies ist insbesondere dann relevant, wenn zeitlich begrenzte, lokale Aussagen über Risiken getroffen werden sollen, wenn gleichzeitig nur Wahrscheinlichkeitsverteilungen zu den Modellparametern vorliegen.

| top |

Quantitative Risikoanalysen mit Bayesschen Netzen |

|

Jedes Unternehmen (eigentlich jedes Unterfangen menschlicher Betätigung) beinhaltet Risiken, die gemanagt werden müssen. Dieses Management ist in industriellen Bereichen teilweise gesetzlich gefordert und dann in vielen Teilen geregelt. Eine Risikoanalyse im Rahmen des Risikomanagements eines Unternehmens ist die Untersuchung und detaillierte Auseinandersetzung mit den durch eine Risikoidentifikation ermittelten Risiken.

Verwendete Verfahren der Risikoanalyse unterscheiden sich darin, auf welchem Skalenniveau Risiken erhoben werden. Qualitative Risikoerhebungen erheben Risiken nur auf sogenannter Nominalskala, bei denen das Ereignis und mögliche Konsequenzen in verbaler Form bekannt sind. Beides kann aber nicht genauer erläutert werden und zugeordnete Eintrittswahrscheinlichkeiten können nicht angegeben werden; auch nicht ordinal (d.h. mit einer Ordnungsrelation). Damit können z.B. Risiken aus einer rein qualitativen Risikoerhebung nicht der Größe nach sortiert werden.

Semiquantitative Risikoerhebung erheben Risiken auf sogenannter Ordinalskala, womit die Risiken der Größe nach sortiert werden können. Damit wird eine Risikopriorisierung möglich, ebenso eine Sortierung nach Maßnahme erforderlich/nicht erforderlich. Typische semiquantitative Analysen beinhalten die Verwendung von Risikomatrizen (wie in vielen Gefährdungsbeurteilungen). Diese Einschätzungen sind sehr grob gerastert und oft unsicherheitsbehaftet.

Quantitative Risikoerhebung erheben Risiken auf sogenannter Kardinalskala. Bei der Kardinalskala handelt es sich um eine metrische Skala, bei der sowohl eine Ordnungsrelation existiert und auch der Abstand interpretierbar ist. Damit ist die Reihenfolge der Risiken auf diesem Skalenniveau festgelegt und auch die Größe des Abstandes zwischen zwei Risiken lässt sich sachlich begründen. Eine quantitative Risikoanalyse verarbeitet das maximal bereitstellbare Wissen zu den Risiken und gibt eine zur Genauigkeit der Eingangsdaten passende Bewertung. Besser geht es methodisch nicht -aber auch nicht aufwändiger. Unterschiede gibt es aber sehr wohl in der Güte verschiedener quantitativer Risikoanalysen. Probleme bestehen dann, wenn eine quantitative Risikoanalyse eine höhere Genauigkeit gegenüber einer semiquantitativen oder qualitativen Risikoerhebung nur vorgaukelt, da sich mit der Bandbreite der Unsicherheiten in den Eingangsdaten nicht auseinandergesetzt wurde. Je nach unternehmerischem Risiko, Produkttyp und Branche haben sich im Risikomanagement unterschiedliche Verfahren und Vorgehensweisen entwickelt.

Innerhalb der Anlagen- und Prozesssicherheit gibt es in Deutschland (mit Außnahme der Kerntechnik) keinen Industriezweig, in dem von Seiten des Gesetzgebers eine quantitative Risikoanalyse gefordert wird. Die gesetzlichen Regelungen sind so, dass der Nachweis des Einhaltens des Standes der Technik bzw. die Festlegung und der Nachweis der Adäquatheit risikobegrenzender oder risikosenkender Maßnahmen auch mit anderen Vorgehensweisen oder nach qualitativen (z. B. PAAG) oder semiquntitativen (z. B. Risikomatrizen) Risikobetrachtungen erfolgen kann. Dadurch werden oft interessante quantitative Erhebungen nicht durchgeführt und entsprechende Analysedaten sind nicht verfügbar. Das theoretisch verfügbare Wissen wird nicht genutzt und getroffene Entscheidungen können (sehr) suboptimal sein. Zudem wird dadurch die quantitative Erfahrung vieler Experten in einem Industriebereich nicht systematisch-kumulativ erfasst bzw. gespeichert und geht mit dem Ausscheiden dieser verloren.

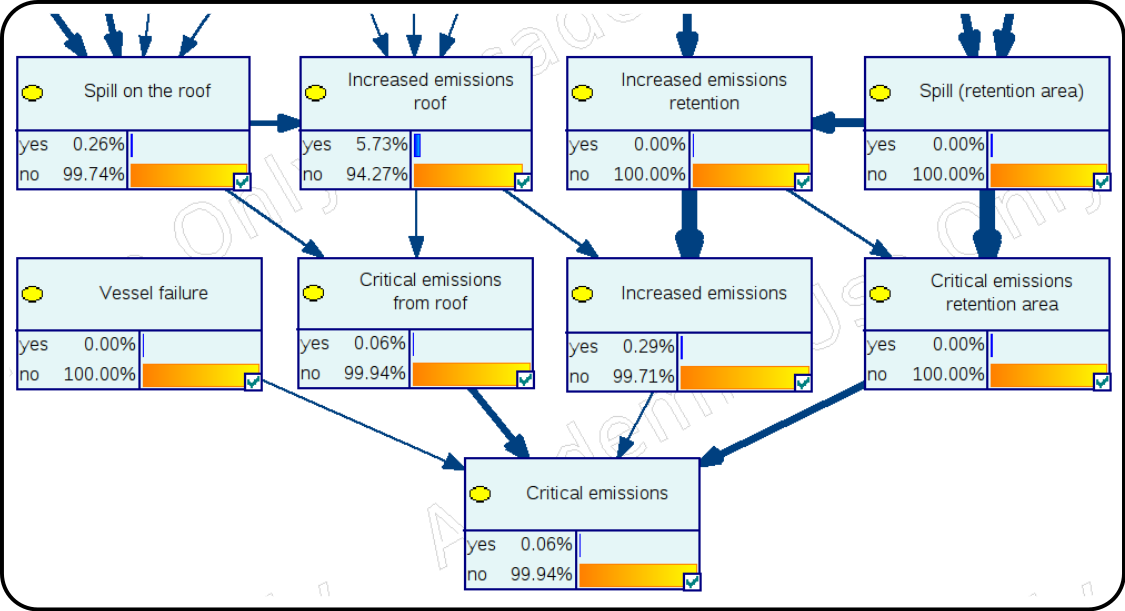

Je stärker ein zu betrachtendes System auf eine Verkettung von elektrischen, bzw. elektronischen Komponenten oder auf mechanischen Komponenten mit hoher Nutzungserfahrung beruht, desto geeigneter sind Beschreibungen mit Fehler- (FTA) oder Ereignisbaumanalysen (ETA). Der Funktionszustand und die Zustandslogik von Schaltkreisen, retundanten Systemkomponenten, verlöteten elektronischen Komponenten, verlegten Kabeln usw. kann gut mit Boolescher Logik wiedergeben werden. Des Weiteren kann man den Ausfall von Serien- oder Massenkomponenten statistisch gut beschreiben. Je mehr Mensch-Maschine-Interaktionen, Softwareschnittstellen oder Verknüpfungen zu (wechselnden) Personalhandlungsstrukturen bestehen und je mehr das Versagen eines Systems nicht von irgendwelchen Schaltkreisen, verlöteten Dingen, verlegten Kabeln usw. abhängt, desto mehr Unkenntnis über das System kann vorliegen. Dann wird es schwer, FTA und ETA anzuwenden. Um hier dennoch eine bestmögliche Prognose abgeben zu können, kann man z. B. mit Bayesschen Netzen arbeiten. Hierin werden nicht selten in Ermangelung von Daten (Messdaten, statistisch gesicherte Daten von Datenbanken) auch Expertenschätzungen einzubeziehen sein.

Bayessche Netze sind flexibler und umfassender (jeder Fehlerbaum kann in ein BN überführt werden, aber die Umkehrung gilt nicht) als vorgenannte Verfahren aber auch anspruchsvoller, besonders was die Beschaffung der Eingangsdaten betrifft. In unserer Forschung beschäftigen wir uns mit der effizienten Anwendbarkeit von BN fü industrierelevante Risikoanalysen, insbesondere bei Vorliegen von System- und Datenunsicherheiten:

| top |

Verwendung der Coupled Cluster Methode |

|

Kooperationen mit dem Institut für theoretische Physik der Universität Magdeburg (Theorie der Kondensierten Materie II)

Die Coupled Cluster Methode (CCM) zählt zu einem überschaubaren Kreis universeller Quanten- Vielteilchen-Methoden, die auf der Grundlage mikroskopischer Daten das Verhalten eines makroskopischen Systems beschreiben.

Die CCM besitzt inzwischen ausgereifte Applikationen in zahlreichen Gebieten der Quantenchemie und der Quantenphysik.

Hier wird eine Applikation der Coupled Cluster Methode zur Berechnung von Erwartungswerten an Quantenspinsystemen verwendet. Hierbei handelt es sich um Abstrahierungen von Festkörperstrukturen zu Gittern, bei denen die Gitterpunkte Träger von lokalisierten magnetischen Momenten (Spins) sind. Somit steht die Untersuchung magnetischer Eigenschaften im Vordergrund. Die entsprechende Modellgrundlage für die Beschreibung des Festkörpermagnetismus liefert das Heisenberg-Modell.

Die verwendete Applikation der Coupled Cluster Methode (C++-Programm) bietet bei der Untersuchung von Quantenspinsystemen die Möglichkeit der:

| top |

Löslichkeiten, Strukturoptimierung und Kristallisation |

|

Kooperationen (z. Z. inaktiv) mit dem MPI für Dynamik Technisch Komplexer Systeme Magdeburg (molecular simulations and design (MSD), physical and chemical foundations of process engineering (PCF))

Zahlreiche verfahrenstechnische Prozesse beruhen auf Abläufen in flüssigen Gemischen. Hierzu zählen z. B. Trennprozesse, katalytische Reaktionen, Kristallisationsprozesse und Transportprobleme.

Zur Auslegung und Beschreibung dieser Prozesse ist es oft erforderlich und sinnvoll, die Gemischzusammensetzung und deren thermodynamisches Verhalten theoretisch zu beschreiben und geeignete Lösungsmittel(gemische) vorherzusagen.

Die verwendeten Vorhersagemethoden erstrecken sich von Molekulardynamik-Simulationen über Gruppenbeitragsmethoden wie UNIFAC bis hin zur Verwendung von COnduktor like Screening MOdels für realistische Löslichkeitsvorhersagen (COSMO-RS, sowie auch COSMO-SAC und Versionen). Molekulardynamik-Simulationen können das Verhalten eines geeigneten Ensembles von Molekülen beschreiben. Die so aufgezeichneten Trajektorien können Aufschluss auf das Wechselwirkungsverhalten und auf die Wechselwirkungswahrscheinlichkeit geben. In der Summe helfen die verwendeten Verfahren bei der Erklärung von experimentell beobachteten Verhaltensweisen und bei der Optimierung von experimentell durchzuführenden Arbeiten.

Anwendung findet die Untersuchungen hier z. B. zur:

| top |